El nuevo chip forma parte de la estrategia de silicio propio de la compañía y apunta a mejorar el rendimiento, la eficiencia energética y los costos de operación de los servicios de IA en la nube.

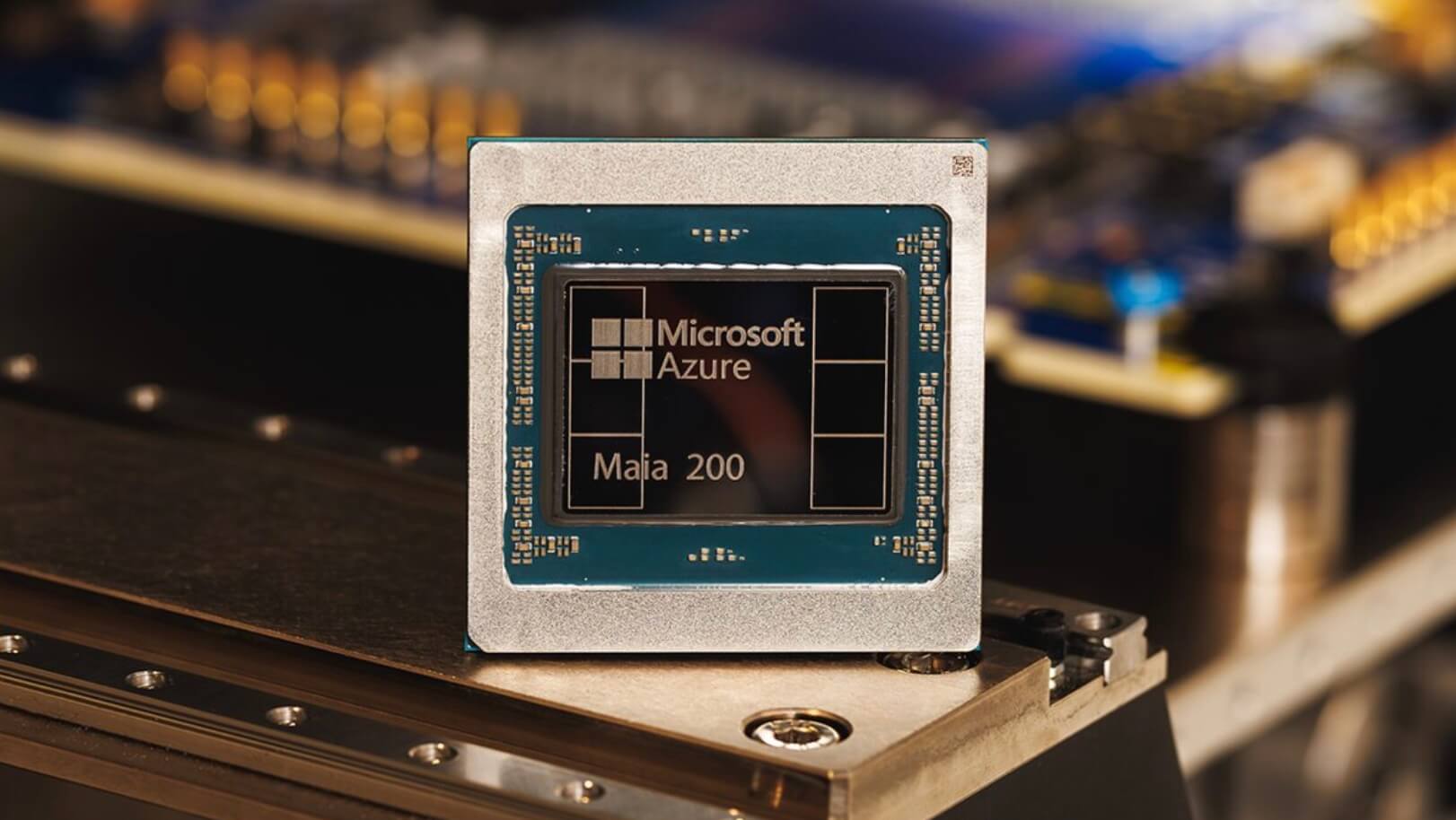

Fabricado con tecnología de 3 nanómetros, Maia 200 integra más de 140 mil millones de transistores y fue diseñado para responder a las demandas de la inteligencia artificial generativa. Según Microsoft, ofrece cerca de un 30 % más de rendimiento por dólar en comparación con el hardware más avanzado que actualmente utiliza en sus centros de datos.

El acelerador está optimizado para modelos que trabajan con computación de baja precisión, clave en la evolución de los grandes modelos de lenguaje. Cada chip supera los 10 petaFLOPS en FP4 y los 5 petaFLOPS en FP8, lo que le permite ejecutar modelos de gran tamaño y prepararse para futuras generaciones. A esto se suma un sistema de memoria rediseñado, con alta capacidad y ancho de banda, que reduce los cuellos de botella asociados al movimiento de datos y acelera la generación de resultados.

Maia 200 será utilizado para ejecutar múltiples modelos de IA en la nube de Microsoft, incluidos los más recientes desarrollos de OpenAI, y tendrá impacto directo en servicios como Copilot y las plataformas de desarrollo de IA de la compañía. También será clave para equipos internos enfocados en investigación avanzada, como la generación de datos sintéticos y el aprendizaje por refuerzo.

A nivel de infraestructura, el sistema permite escalar clústeres de miles de aceleradores mediante una arquitectura de red basada en Ethernet estándar, optimizando costos, consumo energético y flexibilidad operativa en los centros de datos de Azure. Microsoft indicó que el diseño completo fue validado de forma nativa en la nube, lo que permitió una rápida adopción de los primeros modelos apenas el silicio estuvo disponible.

Maia 200 ya se encuentra operativo en regiones de Azure en Estados Unidos y se desplegará progresivamente en otros mercados. Con este anuncio, Microsoft refuerza su apuesta por una infraestructura de IA propia y escalable, anticipando que el desempeño del hardware será un factor decisivo en la próxima etapa de la inteligencia artificial a gran escala.